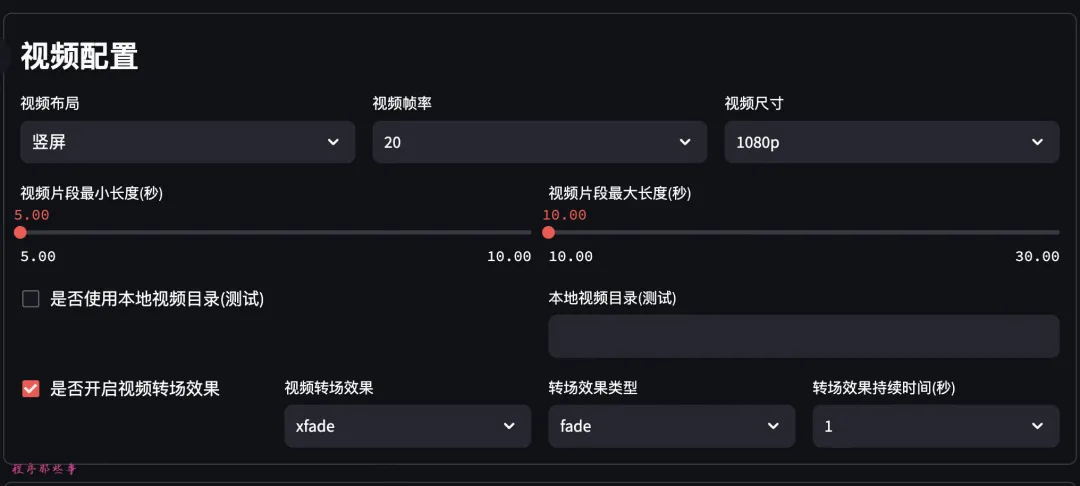

MultiOn 推出了一种类似Q*的新型自主AI代理: Agent Q ,Agent Q拥有自我学习和自我进化能力,Agent Q 能够在复杂的任务中进行多步推理,通过自我规划和执行多个步骤来完成目标任务。

微调后的LLaMa 70B经过一天的自主对弈,性能从18.6%跃升至81.7%, 在线搜索成功率更是达到95.4%。

它能够有效地在动态环境中做出决策,并灵活调整策略以适应不断变化的情况。

Agent Q 在执行任务的每一步都会进行自我评估,并根据反馈调整自己的行为。这种自愈能力使得 Agent Q 能够在遇到错误或障碍时自行纠正,避免陷入不利的决策路径。

Agent Q 能够在没有明确训练数据的情况下,通过自主数据收集和学习,快速提高在新任务中的表现。例如,在网页预订实验中,Agent Q 能够在一天内显著提高任务成功率。

Agent Q 是 Agent 的一个重要里程碑,它结合了搜索、自我批评和强化学习,创建了能够规划和自我修复的最先进的自主网络代理。我们的突破性方法解决了以前的局限性LLM通过引入用于自主网络导航的学习和推理的新颖框架来训练技术。

Agent Q通过将引导式蒙特卡罗树搜索 (MCTS) 和人工智能自我批评与迭代微调相结合,利用直接偏好优化 (DPO) 算法等人类反馈强化学习 (RLFH) 方法进行创新。该方法使LLM智能体从成功和不成功的轨迹中学习,增强其在多步推理任务中的泛化能力。

Agent Q 的关键组件:

MCTS 引导式搜索:该技术通过探索不同的操作和网页、平衡探索和利用来自动生成数据。 MCTS利用高采样温度和多样化的提示来扩展动作空间,确保多样化和最佳的轨迹收集。

人工智能自我批评:在每一步,基于人工智能的自我批评都会提供有价值的反馈,从而完善代理的决策过程。这种阶梯级反馈对于长期任务至关重要,因为稀疏信号通常会导致学习困难。

直接偏好优化:DPO 算法通过从 MCTS 生成的数据构建偏好对来微调模型。这种离策略训练方法允许模型从聚合数据集中有效学习,包括搜索过程中探索的次优分支,从而提高复杂环境中的成功率。

工具集

工具集  博客

博客  标签云

标签云

AI设计

AI设计 AI写作

AI写作  AI音频

AI音频  AI搜索

AI搜索 行业AI

行业AI  AI编程

AI编程 AI聊天

AI聊天 AI模型

AI模型 Ai提示词

Ai提示词