我们很高兴推出 RefuelLLM-2 和 RefuelLLM-2-small,这是我们专为数据标记、丰富和清理而构建的大型语言模型的下一个版本。

RefuelLLM-2 (83.82%) 优于所有最先进的 LLMs,包括 GPT-4-Turbo (80.88%)、Claude-3-Opus (79.19%) 和 Gemini-1.5-Pro (74.59%),跨越约 30 个数据标记任务的基准。

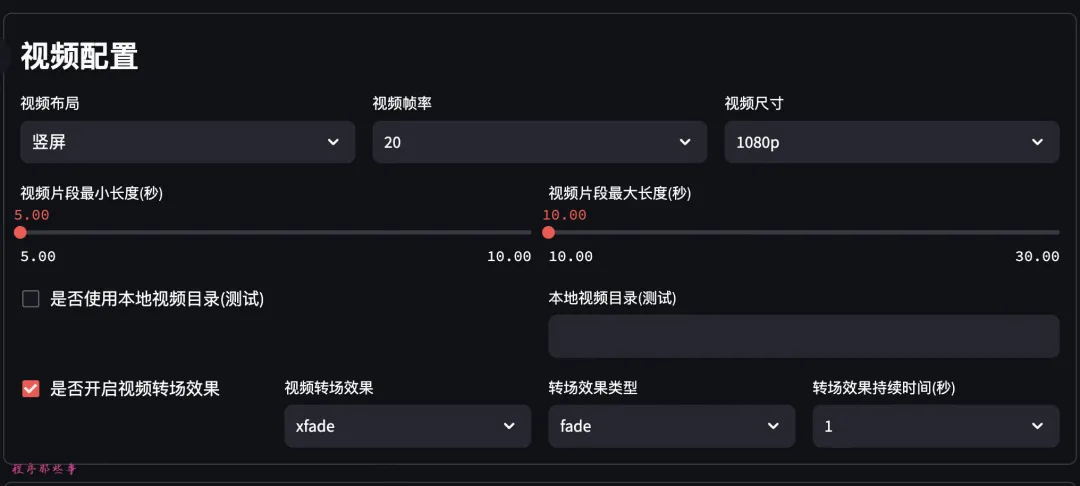

RefuelLLM-2 是 Mixtral-8x7B 基础模型,在包含 2750 多个数据集的语料库上进行训练,涵盖分类、阅读理解、结构化属性提取和实体解析等任务。

RefuelLLM-2-small (79.67%),又名 Llama-3-Refueled,优于所有同类 LLMs,包括 Claude3-Sonnet (70.99%)、Haiku (69.23%) 和 GPT-3.5-Turbo (68.13%) )。它使用相同的配方进行训练,但在 Llama3-8B 基础 LLM 之上。我们正在开源该模型,可在 Hugging Face 上使用。

从今天开始,您可以在我们的 LLM 游乐场中试用这些模型,或者在 Refuel Cloud 中访问它(具有微调支持)。

为什么?

虽然数据是现代企业的燃料,但大量的价值仍然被锁在混乱、不干净和非结构化的数据中。解锁这个价值需要太多的手动工作 - 数据团队花费的 80% 的时间只是在做“不性感”的数据工作(清理、标准化、标记等),然后才能做任何有意义的事情。最先进的 LLMs 擅长所有方面,但很少擅长于您可能关心的少数任务,而且,对于收集的数据规模而言,它们太昂贵且速度太慢或今天生成。我们需要更好的东西 -

结果

基准数据集

与之前推出的 Refuel LLM 相比,我们在基准测试中添加了 10 个数据集:

长上下文数据集:添加了 QuALITY 和 NaturalQuestions 等数据集,以专门评估具有长输入上下文的任务的质量。

非公开评估数据集:由于对数据(有效)的担忧,许多研究人员和从业者最近强调了仅在公共数据集上评估 LLMs 的局限性(阅读[1]、[2]、[3])污染。为了测试LLMs在现实世界的数据标记和丰富任务上的泛化和执行效果,我们还在基准测试中添加了非公开数据集。

我们使用 Autolabel(我们的开源库,用于 LLM 支持的数据标记)来运行本报告中的所有实验。

质量

输出质量衡量 LLM 生成的输出与提供的真实标签的一致性程度。

RefuelLLM-2 (83.82%) 在数据标记和丰富方面优于当前所有最先进的 LLMs,包括 GPT-4-Turbo (80.88%)、Claude-3-Opus (79.19%)和 Gemini-1.5-Pro (74.59%)

RefuelLLM-2-small (79.67%) 在类似的大小/推理成本下优于 LLMs,包括 Claude-3-Sonnet (70.99%)、Haiku (69.23%) 和 GPT-3.5-Turbo (68.13%)

与我们从上述每个模型(分别为 Mixtral-8x7B、Llama3-8B)开始的基础 LLMs 相比,我们看到质量有了显着提高。

长上下文数据集

正如基准测试部分中提到的,我们包含了一些专门用于评估长输入上下文上的 LLM 性能的数据集。

RefuelLLM-2 是 Mixtral-8x7B 基本模型,本身支持 32K 最大输入上下文长度。 RefuelLLM-2-small 是 Llama3-8B 基础模型,支持 8K 最大输入上下文长度。

在两类输入(<4K 和 >=4K 输入上下文)上,我们看到 RefuelLLM-2 的性能优于所有 LLMs。正如预期的那样,我们确实看到所有 LLMs 的长上下文输入的性能显着下降。

非公开数据集

正如基准部分所述,我们在非公开数据集集合上评估了所有 LLMs,涵盖招聘、金融服务、STEM 和电子商务等领域。这些数据集未用作 Refuel-LLM2 模型系列的任何训练或验证拆分的一部分。虽然将这些纳入基准会损害可重复性,但我们认为,在非公开的、特定于任务的数据集上评估 LLMs 至关重要,以便了解它们在现实环境中的可靠性和质量。

RefuelLLM-2 的卓越品质在上面所示的性能比较中得到了加强。此外,对于这两个模型来说,与各自的基础 LLMs 相比,保留数据集的质量提高很好地表明了它们的泛化能力。

特定领域的数据集

为了进一步了解模型在现实环境中的可靠性和质量,我们还报告了特定行业/问题领域的数据集的LLM质量。

我们观察到,在各个垂直领域,与 GPT-4 等当前最先进的 LLMs 相比,Refuel-LLM-2 在输出质量方面具有竞争力或优越性Turbo 和 Claude-3-Opus,尺寸不到模型的 1/10。

信心质量得分

基于我们对“置信度标签”研究的了解,我们使用平均标记生成概率作为估计 LLM 输出置信度的启发式方法。为了对这些置信度分数的质量进行基准测试,我们使用 AUROC。 AUROC 是一个总分,用于衡量分类器在所有分数阈值中区分正类(“LLM 输出正确”)和负类(“LLM 输出不正确”)的能力:

我们观察到,与 GPT-4 和 Llama-3-70B 相比,RefuelLLM-2 和 RefuelLLM-2-small 输出的校准置信度分数要好得多。该领域之前的工作表明,基于 RLHF 的 LLMs 后训练会严重损害 logprob 校准。 RLHF 训练过程可能会导致模型的输出分布与原始预训练分布之间的 KL 散度出现较大峰值。这可能会导致模型显着偏离其原始的“世界先验”,从而损害其准确估计概率的能力。请注意,Claude 和 Google 提供的模型不支持返回 token 级别的对数概率,因此没有分配给它们的分数。

方法

训练和超参数

我们分两个阶段训练模型。第一阶段负责使模型擅长数据标记和丰富任务,而第二阶段有助于提高较长上下文示例的性能。这两个阶段的训练都是在 8xH100 80GB GPU 集群上完成的。

第 1 阶段 - 这是模型大部分指令调整发生的阶段。用于训练的行的最大长度为 4096 个标记。我们训练模型 21k 步骤,批量大小为 32。我们使用余弦学习率调度程序,初始学习率为 1e-5,衰减至其值的 10%。

第 2 阶段 - 在此阶段,我们将更长的上下文输入添加到训练集中,进一步训练模型。我们额外训练模型 5k 步骤,批量大小为 16,梯度累积步骤为 2。我们发现模型在此阶段对学习率更加敏感,并使用余弦学习率调度程序,初始学习率为 2e-6,衰减至其值的 10%。

数据集

虽然两个阶段使用的示例分布不同,但它们是从 2750 多个独特任务的同一集合中采样的。我们的培训系列主要包括:

人工注释的数据集,例如 Flan、Task Source 和 Aya 集合

OpenOrca、OpenHermes 和 WizardLM 等综合数据集

由 Refuel 开发或许可的专有数据集

最终的指令调优数据集(在重复数据删除、采样和清理之后)由两个阶段的约 4B 个令牌组成。我们还利用多重打包,将多个序列打包到一个批次中,以提高训练吞吐量。

使用权

从今天开始可以访问 RefuelLLM-2 模型:

查看 https://labs.refuel.ai/playground,这是一个交互式游乐场,用于针对其他 LLMs 测试模型。

注册 Refuel Cloud 以访问模型以及微调支持:https://www.refuel.ai/ https://www.refuel.ai/get-started

We’re open sourcing RefuelLLM-2-small (aka Llama-3-Refueled) under a CC BY-NC 4.0 license. The model weights are available on Hugging Face: 我们正在 CC BY-NC 4.0 许可证下开源 RefuelLLM-2-small(又名 Llama-3-Refueled)。模型权重可在 Hugging Face 上找到:https://huggingface.co/refuelai/Llama-3-Refueled

致谢

我们感谢 Mistral 提供 Mixtral-8x7B,感谢 Meta 和 NousResearch 向社区提供 llama-v3。

我们要感谢 Flan、Tasksource、OpenHermes、OpenOrca、Aya 等集合的创建者构建并使其开源。我们还要感谢 AllenAI 和 TAU 构建并开源了我们用于训练的几个长上下文数据集。

我们感谢 Transformer、TGI、vLLM、axolotl、deepspeed、FastAttention 和 lorax 的维护者。

最后,我们还要感谢 Databricks Mosaic AI Training、GCP 和 Runpod 提供的基础设施资源,我们在培训和评估方面非常依赖这些资源。

Refuel LLM-2模型下载地址:

工具集

工具集  博客

博客  标签云

标签云

AI设计

AI设计 AI写作

AI写作  AI音频

AI音频  AI搜索

AI搜索 行业AI

行业AI  AI编程

AI编程 AI聊天

AI聊天 AI模型

AI模型 Ai提示词

Ai提示词